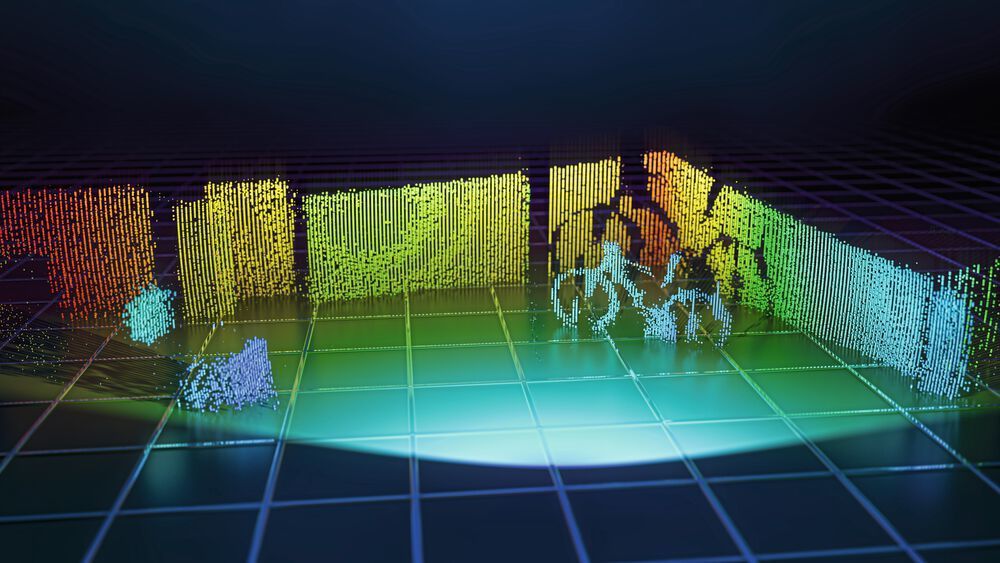

Stereoskopisches Sehen und ausgereifte Datenverarbeitung im Gehirn ermöglichen den Menschen die dreidimensionale Erfassung ihrer Umgebung. Eine zunehmende Anzahl neuartiger Technologien verlangt diese 3D-Sensing Fähigkeit auch von Maschinen und Systemen, oft mit hohen Anforderungen an die Sicherheit und Zuverlässigkeit der jeweiligen Methode.

Ein beliebter und bewährter Ansatz des 3D-Sensing, der dreidimensionalen Erfassung der Umgebung, ist die Distanzbestimmung über die Messung der Flugzeit von Licht, das time-of-flight (ToF) Verfahren. Hierbei wird ein Laserpuls ausgesendet, an einem Objekt reflektiert und anschließend auf einem Bildsensor detektiert, was zum Beispiel bei der Geschwindigkeitsmessung mit Laserpistolen der Polizei zum Einsatz kommt. Dieses LiDAR-Verfahren (engl. Light Detection and Ranging) wird außerdem oft in Fahrerassistenzsystemen, Smartphones und in der Robotik verwendet.

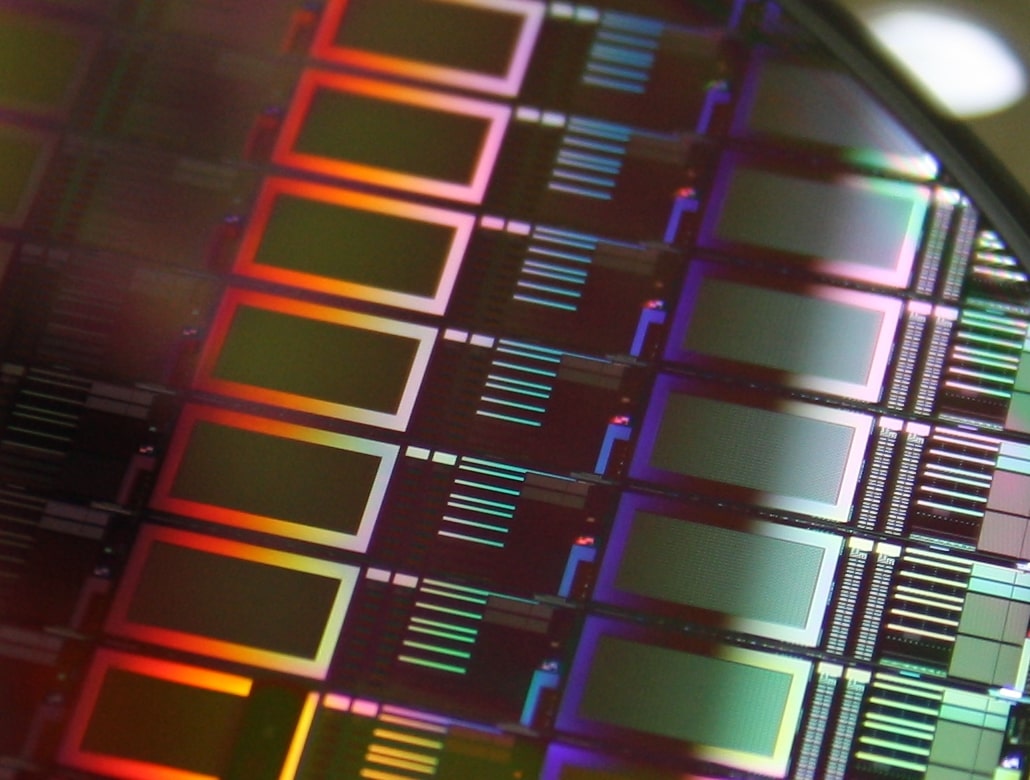

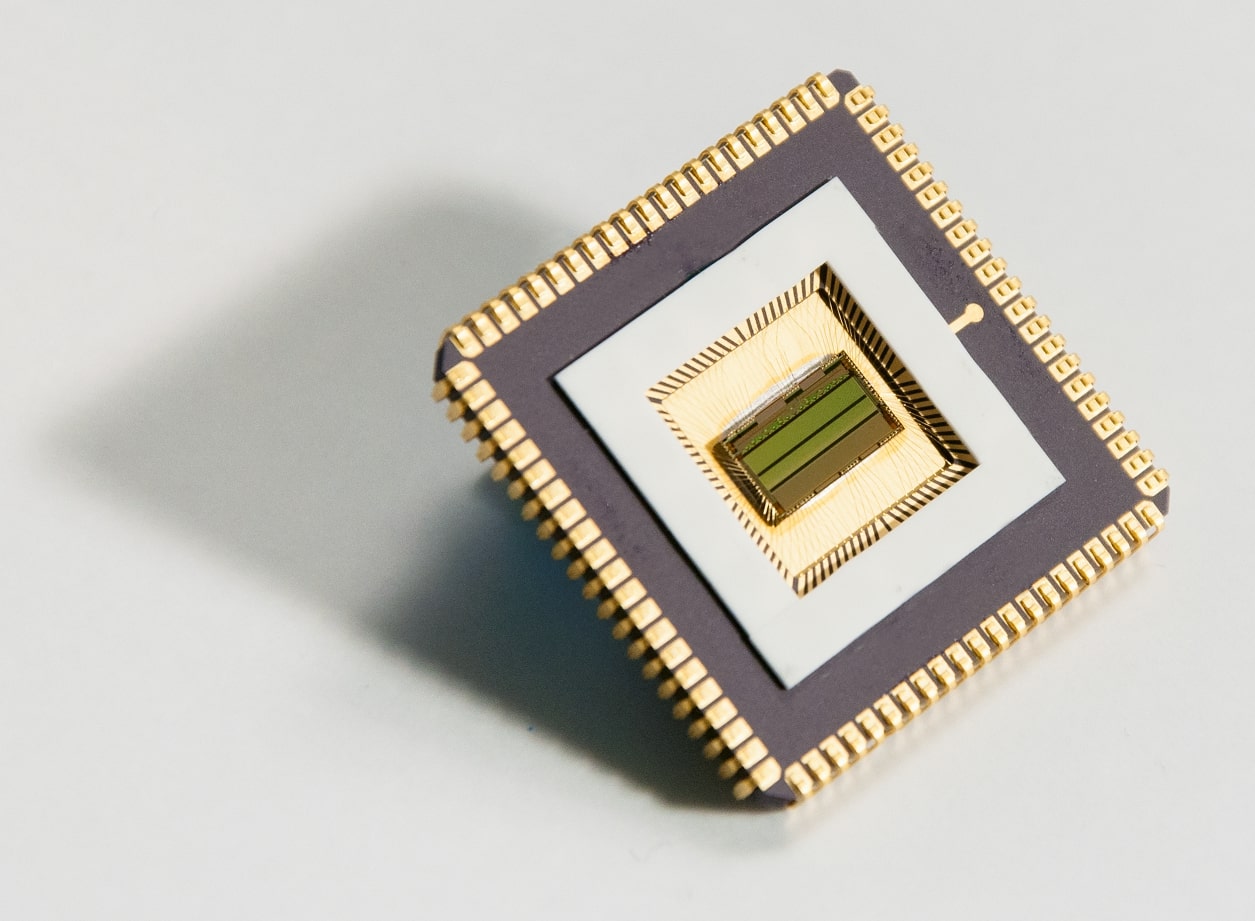

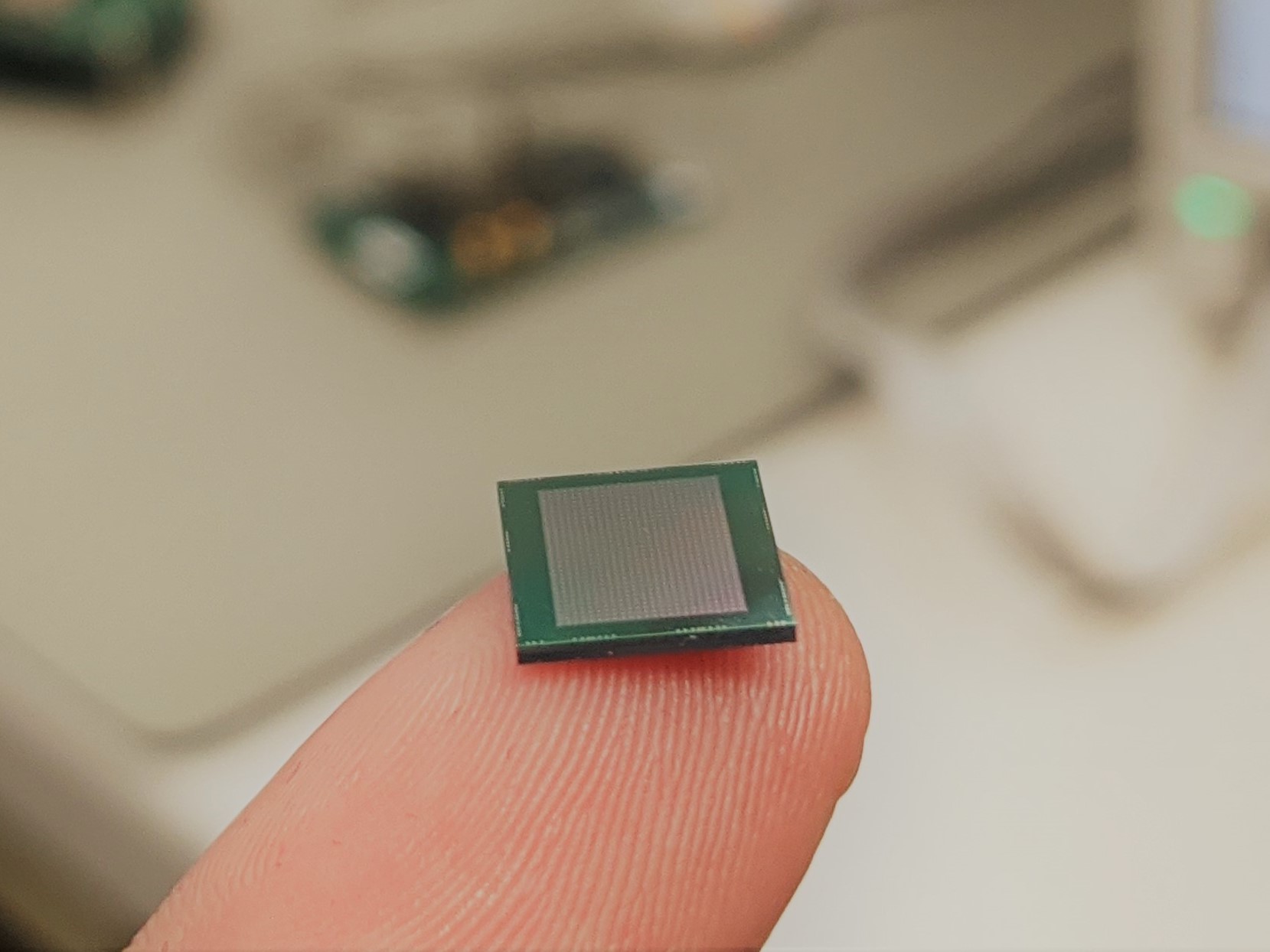

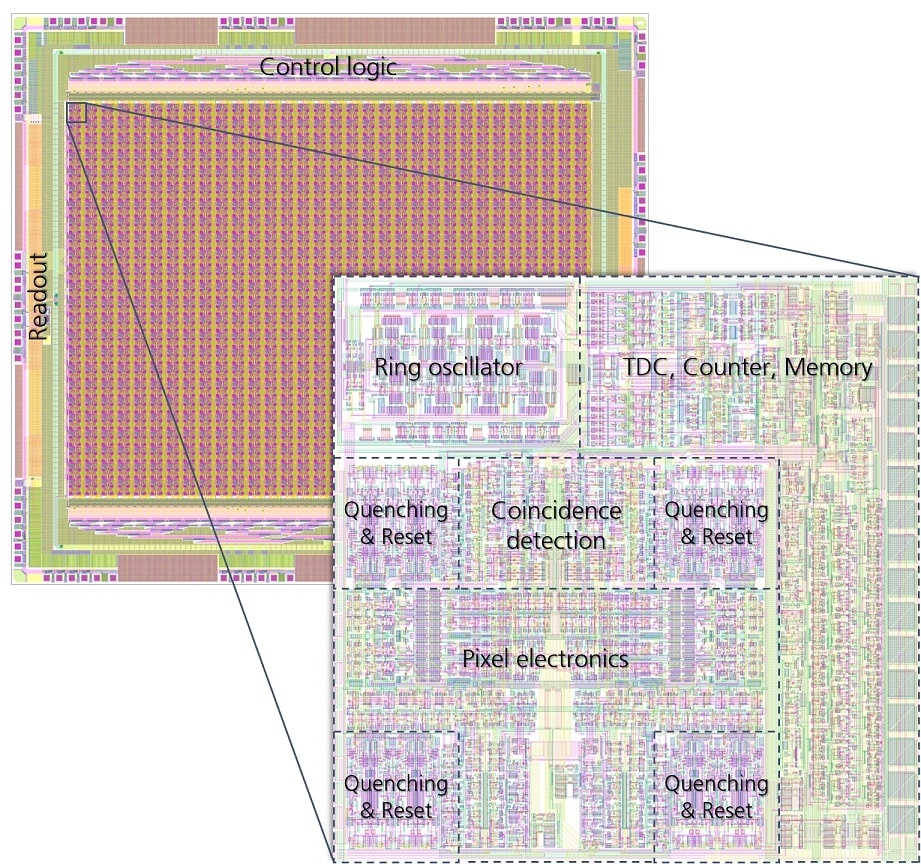

Die weit fortgeschrittene Entwicklung von Lasern und die hohe Lichtgeschwindigkeit erlauben grundsätzlich sehr schnelle Distanzbestimmungen und somit 3D-Sensing in Echtzeit. Dies stellt allerdings enorme Anforderungen an den eingesetzten Bildsensor, der die Fähigkeit besitzen muss, Photonen zuverlässig zu detektieren und dabei die Ankunftszeit mit hoher Auflösung zu ermitteln. Falls die Distanzen verschiedener Punkte im Raum bestimmt werden sollen, sind zudem mehrere Pixel mit unabhängigen zeitbestimmenden Elementen auf dem Bildsensor notwendig.

Besonders bei der Anwendung von LiDAR in autonomen Fahrzeugen kommen weitere Herausforderungen hinzu. Das Hintergrundlicht der Sonne variiert zum Beispiel sehr stark und muss dennoch von dem Laserlicht unterschieden werden. Da hier die Seite des Senders (Laser) durch die Vorgabe der Augensicherheit größtenteils beschränkt ist, wird das Hauptaugenmerk auf die Optimierung des Empfängers (Bildsensors) und der nachfolgenden Datenverarbeitung gelegt.